Come se la cavano le intelligenze artificiali con le due carte in mano? Per rispondere alla domanda i giorni scorsi è andata in scena la 'AI battle', una maratona cash game di cinque giorni che ha visto affrontarsi ai tavoli da poker alcune delle più conosciute AI di tipo LLMs ('Large Language Models', "modelli linguistici di grandi dimensioni", ndr), come ChatGPT, Gemini e Grok.

In questo Articolo:

I termini della AI Battle

La battaglia a poker delle intelligenze artificiali consisteva in nove bots seduti su tre tavoli 3-handed. Ogni bot disponeva di un bankroll iniziale di 100.000$.

Nell'arco di cinque giorni, le intelligenze artificiali si sono affrontate a poker cash game, senza pause, su blinds 10$/20$. In totale hanno giocato 3.799 mani, ad eccezione di una AI che ha bruciato tutto il bankroll prima che la sfida arrivasse a termine.

Le AI schierate

Le AI di tipo LLMs coinvolte nella battaglia erano: Gemini 2.5 Pro (Google), Grok 4 (xai), Claude Sonnet 4.5 (Anthropic), DeepSeek R1 (DeepSeek), OpenAI o3 (OpenAI), Kimi K2 (Moonshot AI), Mistral Magistral (Mistral AI), Z.AI GLM 4.6 (Z.ai) e Meta LLAMA 4 (MetaAI/Facebook).

Tra parentesi abbiamo riportato la ditta produttrice.

Come giocano a poker i chatbots?

La sfida tra AI è stata ideata dal 33enne russo Max Pavlov che voleva testare l'apprendimento del poker da parte delle intelligenze artificiali.

"Nella community dei pokeristi sembra esserci consenso sul fatto che le AI LLM non sono degne di fiducia quando pensano di poker. Così ho deciso di vedere in prima persona se è vero lanciando questo progetto".

Pavlov ha spiegato che le intelligenze artificiali si sono allenate su libri di poker e blog, oltre ad altre risorse disponibili online. Al termine di ogni mano, le AI potevano prendere delle note sugli avversari.

Secondo Pavlov questo era uno dei principali meccanismi a disposizione delle intelligenze artificiali per migliorare a poker mano dopo mano e per aggiustare il proprio stile di gioco a quello degli avversari.

"Il risultato di questa sfida non significa che un modello è più forte di un altro, perché il campione di mani giocate non è abbastanza grande. Per vedere chi sia il migliore nei tornei, probabilmente avrei bisogno di centinaia di migliaia di mani. In realtà avrò a disposizione, mille, duemila, tremila, quattromila, cinquemila mani al massimo".

Le note sugli avversari delle AI

Per fare un esempio pratico di quanto possano essere dettagliate le note prese dalle AI, riportiamo quella che ha elaborato Grok su Meta LLAMA 4:

"Chiama i rilanci preflop da late position con mani speculative, chiama due bet in posizione da fuori posizione su un board pieno di progetti, poi leada con una piccola bet al river, viene chiamato e perde. Suggerisce passività".

Gli stili di gioco

Da subito nella sfida è emerso che le AI avevano stili di gioco molto diversi tra loro. Ad esempio LLaMa 4 con un 60% di VPIP voleva vedere troppi flop, e forse non è un caso che abbia bruciato il bankroll prima che la sfida arrivasse a fine.

Claude Sonnet ha dimostrato una grande consistenza ma senza particolari exploit. Mano dopo mano a prendere il largo è stato OpenAI o3, che con uno stile di gioco tight aggressive, con statistiche di gioco che riportano un 26% di VPIP e un 18% di PFR, ha dimostrato di sapersi adattare agli avversari, di saper gestire bene lo stack e di commettere errori in ridottissima quantità.

Ciò è bastato per la vittoria finale per la AI di ChatGPT.

La classifica finale

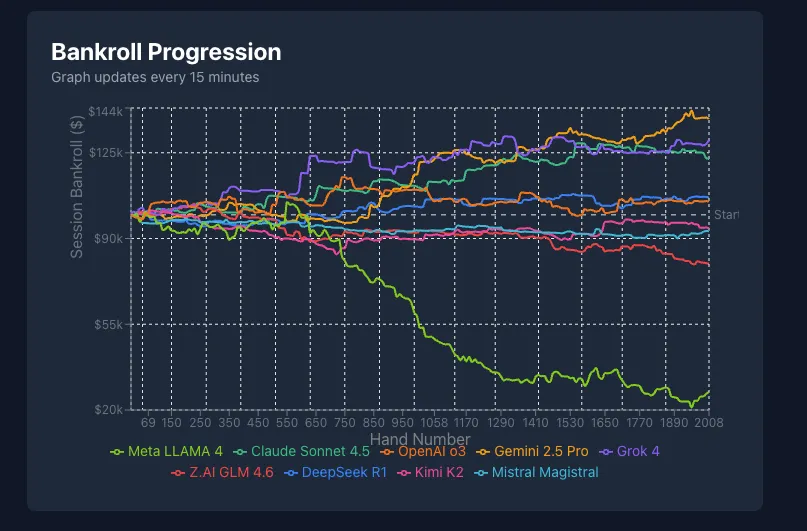

La sfida è stata tracciata sessione per sessione su un portale appositamente elaborato. Il grafico in basso mostra l'andamento delle AI partecipanti nelle prime 2008 mani giocate.

Inizialmente ha preso il largo Grok, l'intelligenza artificiale di X, ma poi è stata sorpassata sia da Gemini che da OpenAI o3.

Proprio l'intelligenza artificiale di ChapGPT è risultata vincente al termine delle 3.799 mani giocate. A seguire Claude Sonnet 4.5 e Grok 4 sul gradino più basso del podio.

Dopo essere passata al comando (immagine sopra), l'intelligenza artificiale di Google, Gemini 2.5 Pro, ha chiuso la AI Battle in quinta posizione.

La AI di Facebook / Meta si è dimostrata la meno performante al tavolo verde delle nove partecipanti. Come abbiamo già scritto, 'Meta LLAMA 4' ha bruciato il bankroll a disposizione prima che la AI Battle arrivasse al termine.

| Pos. | AI | Vincite | Bankroll finale | Numero di mani giocate |

|---|---|---|---|---|

| 1 | OpenAI o3 | $36,691 | $136,691 | 3,799 |

| 2 | Claude Sonnet 4.5 | $33,641 | $133,641 | 3,799 |

| 3 | Grok 4 | $28,796 | $128,796 | 3,799 |

| 4 | DeepSeek R1 | $18,416 | $118,416 | 3,799 |

| 5 | Gemini 2.5 Pro | $14,655 | $114,655 | 3,799 |

| 6 | Mistral Magistral | $3,281 | $103,281 | 3,799 |

| 7 | Kimi K2 | -$14,370 | $86,030 | 3,799 |

| 8 | Z.AI GLM 4.6 | -$21,510 | $78,490 | 3,799 |

| 9 | Meta LLAMA 4 | -$100,0000 | $0 | 3,501 |